Pubblicato 3 gennaio 2022

Aggiornato 15 gennaio 2024

In questa ricerca un team di ricercatori della Lincoln University di Londra e dell’Università di San Paolo in Brasile ha dimostrato che i cani sono in grado di estrarre e integrare informazioni emotive sensoriali bimodali e discriminare tra emozioni positive e negative sia negli esseri umani che nei cani.

Nell’esperimento infatti i soggetti sperimentali, 17 cani adulti, sani e socializzati e di diverse razze, si sono mostrati in grado di estrarre le informazioni emotive da una modalità sensoriale e attivare il modello di categoria emotiva corrispondente per l’altra modalità. Ciò indica che i cani domestici interpretano volti e vocalizzazioni utilizzando più che semplici processi discriminativi; ottengono contenuto semantico emotivamente significativo da stimoli audio e visivi rilevanti che possono aiutare la comunicazione e l’interazione sociale.

Questo capacità attesta che i cani hanno delle rappresentazioni mentali ben chiare dei nostri stati emotivi, sia positivi che negativi, e non mostrano semplicemente comportamenti appresi quando rispondono alle espressioni di persone e altri cani. Infatti l’integrazione di segnali emotivi congruenti attraverso gli input sensoriali cross-modali richiede una rappresentazione categorica interna e quindi fornisce un mezzo per dimostrare la rappresentazione delle emozioni.

La capacità di riconoscere le emozioni attraverso segnali visivi e uditivi può essere uno strumento sociale particolarmente vantaggioso in una specie altamente sociale come i cani e potrebbe essere stata sfruttata per stabilire e mantenere relazioni a lungo termine con gli esseri umani. È possibile che durante l’addomesticamento tali caratteristiche siano state mantenute e potenzialmente selezionate, anche se inconsciamente.

Questa abilità cognitiva (categorizzazione degli stati emotivi eterospecifici) possono essere fondamentali per una relazione funzionale all’interno dei gruppi sociali di specie miste in cui spesso vivono i cani. Inoltre, i risultati di questo studio potrebbero indicare una distribuzione più diffusa della capacità di integrare spontaneamente segnali multimodali tra i mammiferi non umani, che potrebbe essere la chiave per comprendere l’evoluzione della cognizione sociale.

Di seguito la traduzione libera in Italiano dell’articolo.

Link al pdf dell’articolo originale:

I cani riconoscono le emozioni canine e umane

di Natalia Albuquerque, Kun Guo, Anna Wilkinson, Carine Savalli, Emma Otta e Daniel Mills

Pubblicato:01 gennaio 2016 https://doi.org/10.1098/rsbl.2015.0883

Abstract

La percezione delle espressioni emotive consente agli animali di valutare le intenzioni e le motivazioni sociali reciproche. Questo di solito avviene all’interno delle specie; tuttavia, nel caso dei cani domestici, potrebbe essere vantaggioso riconoscere le emozioni degli esseri umani così come quelle degli altri cani. In questo senso, la combinazione di segnali visivi e uditivi per classificare le emozioni degli altri facilita l’elaborazione delle informazioni e indica rappresentazioni cognitive di alto livello. Utilizzando un paradigma di aspetto preferenziale cross-modale, abbiamo presentato ai cani volti umani o canini con diverse valenze emotive (felice/giocoso contro arrabbiato/aggressivo) accoppiati con una singola vocalizzazione dello stesso individuo con una valenza positiva o negativa o rumore browniano. I cani guardavano significativamente più a lungo il volto la cui espressione era congruente alla valenza della vocalizzazione, sia per i conspecifici che per gli eterospecifici, un’abilità precedentemente nota solo negli esseri umani. Questi risultati dimostrano che i cani possono estrarre e integrare informazioni emotive sensoriali bimodali e discriminare tra emozioni positive e negative sia negli esseri umani che nei cani.

1. Introduzione

Il riconoscimento delle espressioni emotive consente agli animali di valutare le intenzioni sociali e le motivazioni degli altri1. Ciò fornisce informazioni cruciali su come comportarsi in diverse situazioni che coinvolgono la creazione e il mantenimento di relazioni a lungo termine2. Pertanto, leggere le emozioni degli altri ha un enorme valore adattivo. La capacità di riconoscere e rispondere in modo appropriato a questi segnali presenta vantaggi in termini di fitness biologico sia per il segnalatore che per il ricevente.

Durante le interazioni sociali, gli individui utilizzano una serie di modalità sensoriali, come segnali visivi e uditivi, per esprimere emozioni con cambiamenti caratteristici sia nel viso che nella vocalizzazione, che insieme producono una percezione più robusta3. Sebbene le espressioni facciali siano riconosciute come un canale primario per la trasmissione di informazioni affettive in una vasta gamma di specie, la percezione delle emozioni attraverso l’integrazione sensoriale cross-modale consente un riconoscimento più rapido, accurato e affidabile4. L’integrazione cross-modale di segnali emotivi è stata osservata in alcune specie di primati con stimoli conspecifici, come l’abbinamento di una specifica espressione facciale con la corrispondente vocalizzazione o chiamata5. Tuttavia, attualmente non esistono prove di riconoscimento emotivo degli eterospecifici negli animali non umani. Comprendere le emozioni eterospecifiche è di particolare importanza per animali come i cani domestici, che vivono la maggior parte della loro vita in gruppi di specie miste e hanno sviluppato meccanismi per interagire con gli esseri umani (ad esempio6). Alcuni lavori hanno dimostrato capacità cross-modali nei cani in relazione alla percezione di attività specifiche (ad esempio la guardia del cibo)7[9] o caratteristiche individuali (ad esempio le dimensioni del corpo)8, ma non è chiaro se questa capacità si estenda all’elaborazione di segnali emotivi, che informano gli individui sullo stato interno degli altri.

I cani possono discriminare le espressioni facciali umane e i suoni emotivi (ad esempio9); tuttavia, non vi è ancora evidenza di un’integrazione emotiva multimodale e questi risultati relativi alla discriminazione potrebbero essere spiegati attraverso semplici processi associativi. Non dimostrano riconoscimento emotivo, il che richiede la dimostrazione della categorizzazione piuttosto che della differenziazione. L’integrazione di segnali congruenti attraverso gli input sensoriali richiede una rappresentazione categorica interna e quindi fornisce un mezzo per dimostrare la rappresentazione delle emozioni.

In questo studio, abbiamo utilizzato un paradigma di sguardo preferenziale cross-modale senza fase di familiarizzazione per testare l’ipotesi che i cani possano estrarre e integrare informazioni emotive da input visivi (facciali) e uditivi (vocali). Se i cani riescono a riconoscere le emozioni in modo incrociato, dovrebbero guardare più a lungo le espressioni facciali che corrispondono alla valenza emotiva delle vocalizzazioni presentate simultaneamente, come dimostrato da altri mammiferi (ad esempio [5–7, e10). A causa dei risultati precedenti di distorsioni di valenza11, lato12, sesso13e specie14 negli studi sulla percezione, abbiamo anche studiato se questi quattro fattori principali avrebbero influenzato la risposta dei cani.

2. Materiali e metodi

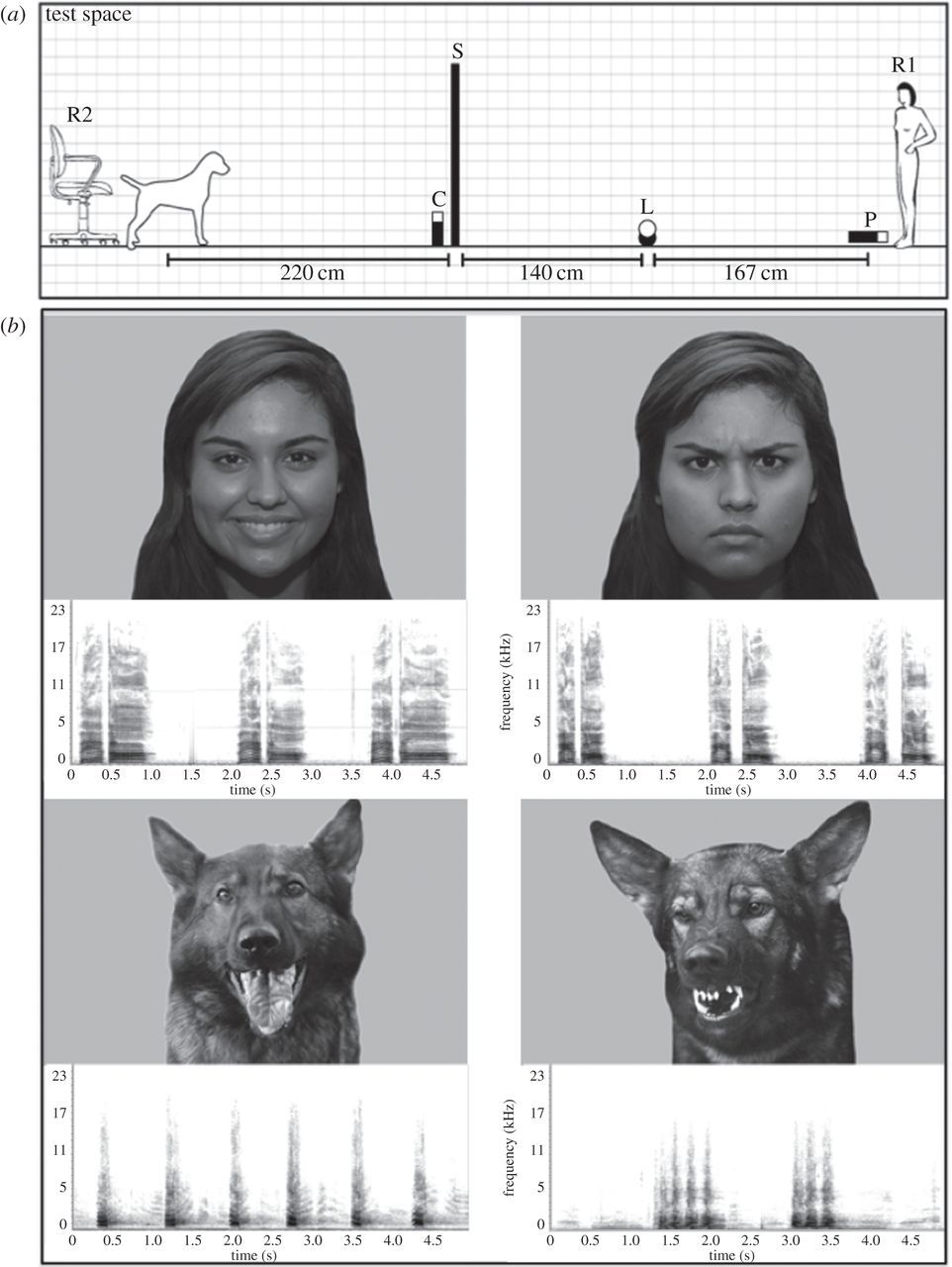

A diciassette cani adulti di famiglia sani e socializzati di varie razze sono stati presentati simultaneamente due fonti di informazioni emotive. Coppie di immagini di volti umani o di cani con correzione gamma in scala di grigi dello stesso individuo ma raffiguranti espressioni diverse (felice/giocoso contro arrabbiato/aggressivo) sono state proiettate su due schermi contemporaneamente mentre veniva riprodotto un suono (figura 1a). Il suono era una singola vocalizzazione (abbaiare di cane o voce umana in una lingua sconosciuta) di valenza positiva o negativa dello stesso individuo, o un suono neutro (rumore browniano). Gli stimoli (figura 1b) presentavano una femmina e un maschio di entrambe le specie. Individui non familiari e una lingua sconosciuta (portoghese brasiliano) sono stati utilizzati per escludere la potenziale influenza di precedenti esperienze con l’identità del modello e il linguaggio umano.

Figura 1. (a) Apparato schematico. R2: ricercatore, C: telecamera, S: schermi, L: altoparlanti, P: proiettori, R1: ricercatore. (b) Esempi di stimoli utilizzati nello studio: volti (umano felice contro arrabbiato, cane giocoso contro aggressivo) e le loro vocalizzazioni corrispondenti.

Gli esperimenti si sono svolti in una sala prove tranquilla e scarsamente illuminata e ciascun cane ha ricevuto due sessioni di 10 prove, separate da due settimane. I cani stavano davanti a due schermi e una videocamera registrava il loro comportamento spontaneo. Una prova consisteva nella presentazione di una combinazione di stimoli acustici e visivi ed è durata 5 secondi (vedere il materiale supplementare elettronico per i dettagli). Ogni prova è stata considerata valida per le analisi quando il cane ha guardato le immagini per almeno 2,5 s. Le 20 prove presentavano diverse combinazioni di stimoli: 4 coppie di volti (2 modelli umani e 2 cani) × 2 vocalizzazioni (valenza positiva e negativa) × 2 posizioni del viso (sinistra e destra), oltre a 4 prove di controllo (4 coppie di volti con stimolo uditivo neutro). Pertanto, ogni soggetto ha visto ogni possibile combinazione una volta.

Abbiamo calcolato un indice di congruenza = (C − I)/T, dove C e I rappresentano la quantità di tempo in cui il cane ha guardato i volti congruenti (espressione facciale corrispondente alla vocalizzazione emotiva, C) e incongruenti (I), e T rappresenta lo sguardo totale tempo (guardando a sinistra + guardando a destra + guardando al centro) per la prova data, per misurare la sensibilità del cane ai segnali emotivi audiovisivi forniti simultaneamente. Abbiamo analizzato l’indice di congruenza in tutti gli studi utilizzando un modello misto lineare generale (GLMM) con il singolo cane incluso nel modello come effetto casuale. Solo la valenza emotiva, il sesso dello stimolo, la specie dello stimolo e la posizione di presentazione (sinistra contro destra) sono stati inclusi come effetti fissi nell’analisi finale perché le interazioni di primo e secondo ordine non erano significative. Le medie sono state confrontate con zero e sono stati presentati gli intervalli di confidenza per tutti i principali fattori di questo modello. Per identificare i fattori significativi è stata applicata una procedura di selezione a ritroso. L’ipotesi di normalità è stata verificata ispezionando visivamente i grafici dei residui senza identificare deviazioni importanti dalla normalità. Per verificare una possibile interazione tra il sesso dei soggetti e gli stimoli, abbiamo utilizzato un GLMM separato tenendo conto di questi fattori. Abbiamo anche testato se i cani osservassero preferenzialmente una particolare valenza durante le prove e un particolare volto nelle prove di controllo (vedere il materiale supplementare elettronico per i dettagli sul calcolo dell’indice).

3. Risultati

I cani hanno mostrato una chiara preferenza per la faccia congruente nel 67% delle prove (n = 188). L’indice di congruenza medio era 0,19 ± 0,03 in tutte le prove ed era significativamente maggiore di zero (t16 = 5,53; p < 0,0001), indicando che i cani guardavano significativamente più a lungo il volto la cui espressione corrispondeva alla valenza della vocalizzazione. Inoltre, abbiamo trovato una preferenza per l’aspetto congruente coerente indipendentemente dalla specie di stimolo (cane: t167 = 5,39, p <0,0001; umano: t167 = 2,48, p = 0,01; figura 2a), dalla valenza emotiva (negativa: t167 = 5,01, p < 0,0001; positivo: t167 = 2,88, p = 0,005; figura 2b), dal genere dello stimolo (femmina: t167 = 4,42, p <0,0001; maschio: t167 = 3,45, p <0,001; figura 2c) e dalla posizione dello stimolo (lato sinistro: t167 = 2,74, p < 0,01; lato destro: t167 = 5,14, p < 0,0001; figura 2d). Quando al modello è stata applicata una procedura di selezione a ritroso con i quattro fattori principali, il modello finale includeva solo le specie stimolo. L’indice di congruenza per questo modello era significativamente più alto per la visualizzazione di volti di cani piuttosto che di volti umani (cane: 0,26 ± 0,05, umano: 0,12 ± 0,05, F1.170 = 4,42; p = 0,04, figura 2a), indicando che i cani hanno dimostrato una maggiore sensibilità verso segnali conspecifici. In un modello separato, non abbiamo osservato alcuna interazione significativa tra il sesso del soggetto e il sesso dello stimolo (F1.169 = 1,33, p = 0,25) o gli effetti principali (sesso del soggetto: F1.169 = 0,17, p = 0,68; stimolo del soggetto: F1.169 = 0,56, p = 0,45).

Figura 2. Comportamento visivo dei cani (calcolato come indice di congruenza). (a) Specie di stimolo; (b) valenza dello stimolo; (c) sesso dello stimolo; (d) lato della presentazione dello stimolo. *p <0,05, **p <0,01, ***p <0,001.

I cani non guardavano preferenzialmente nessuna delle espressioni facciali in condizioni di controllo quando la vocalizzazione era il suono neutro (media: 0,04 ± 0,07; t16 = 0,56; p = 0,58). L’indice medio di sguardo preferenziale era -0,05 ± 0,03, che non era significativamente diverso da zero (t16 = -1,6, p = 0,13), indicando che non c’era differenza nella proporzione del tempo di visione tra le espressioni facciali positive e negative nei trial.

4. Discussione

I risultati sono, a nostro avviso, la prima prova dell’integrazione di espressioni emotive eterospecifiche in una specie diversa dall’uomo, ed estendono oltre i primati la dimostrazione dell’integrazione cross-modale di espressioni emotive conspecifiche. Questi risultati mostrano che i cani domestici possono ottenere informazioni emotive sui cani e sugli esseri umani da input sia uditivi che visivi e integrarli in una percezione coerente delle emozioni15. Pertanto, è probabile che i cani possiedano almeno i prototipi mentali per la categorizzazione emotiva (affetti positivi rispetto a quelli negativi) e possano riconoscere il contenuto emotivo di queste espressioni. Inoltre, i cani si sono comportati in questo modo senza alcun addestramento o familiarità con i modelli, suggerendo che questi segnali emotivi sono intrinsecamente importanti. Ciò è coerente con questa capacità che conferisce importanti vantaggi adattativi16.

Il nostro studio mostra che i cani possiedono una capacità simile ad alcuni primati non umani nel riuscire ad abbinare informazioni emotive uditive e visive, ma dimostra anche un importante progresso. Nel nostro studio, non c’era una stretta correlazione temporale tra la registrazione di segnali visivi e uditivi (ad esempio il muso rilassato del cane con la bocca aperta abbinato ad un abbaio giocoso), a differenza della precedente ricerca sui primati (ad esempio17. Pertanto la relazione tra le modalità non era temporalmente contigua, riducendo la probabilità che le associazioni apprese rendessero conto dei risultati. Ciò suggerisce l’esistenza di una robusta rappresentazione categorica delle emozioni.

Sebbene i cani mostrassero la capacità di riconoscere segnali emotivi sia conspecifici che eterospecifici, abbiamo scoperto che rispondevano in modo significativamente più forte agli stimoli dei cani. Ciò potrebbe essere spiegato da un meccanismo più raffinato per la categorizzazione delle informazioni emotive provenienti dai conspecifici, che è corroborato dalle recenti scoperte di cani che mostrano una maggiore sensibilità alle espressioni facciali dei conspecifici18 e una preferenza per le immagini dei cani rispetto a quelle umane19. La capacità di riconoscere le emozioni attraverso segnali visivi e uditivi può essere uno strumento sociale particolarmente vantaggioso in una specie altamente sociale come i cani e potrebbe essere stata sfruttata per stabilire e mantenere relazioni a lungo termine con gli esseri umani. È possibile che durante l’addomesticamento tali caratteristiche siano state mantenute e potenzialmente selezionate, anche se inconsciamente. Tuttavia, il valore comunicativo dell’emozione è una delle componenti fondamentali del processo e anche le specie domestiche meno sociali, come i gatti, esprimono stati affettivi come il dolore in faccia20.

C’è stato un dibattito di lunga data sulla capacità dei cani di riconoscere le emozioni umane. Studi che utilizzano stimoli visivi o uditivi hanno osservato che i cani possono mostrare risposte comportamentali differenziali a input sensoriali a modalità singola con diverse valenze emotive (ad esempio21). Ad esempio, Müller et al.22 hanno scoperto che i cani potevano rispondere selettivamente alle espressioni facciali umane felici o arrabbiate; quando addestrati solo con la metà superiore (o inferiore) dei volti non familiari, hanno generalizzato la discriminazione appresa all’altra metà del viso. Tuttavia, queste risposte comportamentali modulate dall’espressione umana potrebbero essere attribuite esclusivamente all’apprendimento di caratteristiche visive contigue. In questo senso, i cani potrebbero discriminare le espressioni facciali umane senza riconoscere le informazioni trasmesse.

I nostri soggetti dovevano essere in grado di estrarre le informazioni emotive da una modalità e attivare il modello di categoria emotiva corrispondente per l’altra modalità. Ciò indica che i cani domestici interpretano volti e vocalizzazioni utilizzando più che semplici processi discriminativi; ottengono contenuto semantico emotivamente significativo da stimoli audio e visivi rilevanti che possono aiutare la comunicazione e l’interazione sociale. Inoltre, l’uso di parole portoghesi non familiari ha controllato la presenza di potenziali artefatti indotti dalla precedente esperienza di un cane con parole specifiche. La capacità di formare rappresentazioni emotive che includono più di una modalità sensoriale suggerisce capacità cognitive non precedentemente dimostrate al di fuori dei primati. Inoltre, la capacità dei cani di estrarre e integrare tali informazioni da uno stimolo umano non familiare dimostra capacità cognitive di cui non è nota l’esistenza al di fuori degli esseri umani. Queste abilità possono essere fondamentali per una relazione funzionale all’interno dei gruppi sociali di specie miste in cui spesso vivono i cani. Inoltre, i nostri risultati potrebbero indicare una distribuzione più diffusa della capacità di integrare spontaneamente segnali multimodali tra i mammiferi non umani, che potrebbe essere la chiave per comprendere l’evoluzione della cognizione sociale.

Etica

L’approvazione etica è stata concessa dal comitato etico della School of Life Sciences, Università di Lincoln. Prima dello studio, è stato ottenuto il consenso informato scritto dai proprietari dei cani e dai modelli umani le cui immagini del volto e vocalizzazioni sono state campionate come stimoli. Possiamo confermare che entrambi i modelli umani abbiamo accettato che le immagini dei loro volti e le loro vocalizzazioni possano essere utilizzate per ricerche e pubblicazioni correlate e abbiamo ricevuto il loro consenso scritto.

Accessibilità dei dati

I dati alla base di questo studio sono disponibili da Dryad: http://dx.doi.org/10.5061/dryad.tn888.

- Schmidt KL, Cohn JF, 2001 Human expressions as adaptations: evolutionary questions in facial expression research. Am. J. Phys. Anthropol. 33, 3–24. (doi:10.1002/ajpa.20001) Crossref, PubMed, ISI, Google Scholar ↩︎

- Parr LA, Winslow JT, Hopkins WD, de Waal FBM, 2000 Recognizing facial cues: individual discrimination by chimpanzees (Pan troglodytes) and rhesus monkeys (Macaca mulatta). J. Comp. Psychol. 114, 47–60. (doi:10.1037/0735-7036.114.1.47) Crossref, PubMed, ISI, Google Scholar ↩︎

- Campanella S, Belin P 2007, Integrating face and voice in person perception. Trends Cogn. Sci. 11, 535–543. (doi:10.1016/j.tics.2007.10.001) Crossref, PubMed, ISI, Google Scholar ↩︎

- Yuval-Greenberg S, Deouell LY, 2009 The dog’s meow: asymmetrical interaction in cross-modal object recognition. Exp. Brain Res. 193, 603–614. (doi:10.1007/s00221-008-1664-6) Crossref, PubMed, ISI, Google Scholar ↩︎

- Ghazanfar AA, Logothetis NK, 2003 Facial expressions linked to monkey calls. Nature 423, 937–938. (doi:10.1038/423937a) Crossref, PubMed, ISI, Google Scholar; Payne C, Bachevalier J, 2013Crossmodal integration of conspecific vocalizations in rhesus macaques. PLoS ONE 8, e81825. (doi:10.1371/journal.pone.0081825) Crossref, PubMed, ISI, Google Scholar ↩︎

- Nagasawa M, Mitsui S, En S, Ohtani N, Ohta M, Sakuma Y, Onaka T, Mogi K, Kikusui T, 2015 Oxytocin-gaze positive loop and the coevolution of human-dog bonds. Science 348, 333–336. (doi:10.1126/science.1261022) Crossref, PubMed, ISI, Google Scholar ↩︎

- Faragó T, Pongrácz P, Range F, Virányi Z, Miklósi A., 2010 ‘The bone is mine’: affective and referential aspects of dog growls. Anim. Behav. 79, 917–925. (doi:10.1016/j.anbehav.2010.01.005) Crossref, ISI, Google Scholar ↩︎

- Taylor AM, Reby D, McComb K., 2011 Cross modal perception of body size in domestic dogs (Canis familiaris). PLoS ONE 6, e0017069. (doi:10.1371/journal.pone.0017069) Crossref, ISI, Google Scholar ↩︎

- Nagasawa M, Murai K, Mogi K, Kikusui T. 2011, Dogs can discriminate human smiling faces from blank expressions. Anim. Cogn. 14, 525–533. (doi:10.1007/s10071-011-0386-5) Crossref, PubMed, ISI, Google Scholar; Andics A, Gácsi M, Faragó T, Kis A, Miklósi A, 2014 Voice-sensitive regions in the dog and human brain are revealed by comparative fMRI. Curr. Biol. 24, 574–578., (doi:10.1016/j.cub.2014.01.058) Crossref, PubMed, ISI, Google ↩︎

- Proops L, McComb K, Reby D., 2009 Cross-modal individual recognition in domestic horses (Equus caballus). Proc. Natl Acad. Sci. USA 106, 947–951. (doi:10.1073/pnas.0809127105) Crossref, PubMed, ISI, Google Scholar, Proops L, McComb K., 2012Cross-modal individual recognition in domestic horses (Equus caballus) extends to familiar humans. Proc. R. Soc. B282, 3131–3138. (doi:10.1098/rspb.2012.0626) Link, ISI, Google Scholar ↩︎

- Ghazanfar AA, Logothetis NK., 2003 Facial expressions linked to monkey calls. Nature 423, 937–938. (doi:10.1038/423937a) Crossref, PubMed, ISI, Google Scholar ↩︎

- Proops L, McComb K., 2012, Cross-modal individual recognition in domestic horses (Equus caballus) extends to familiar humans. Proc. R. Soc. B282, 3131–3138. (doi:10.1098/rspb.2012.0626) Link, ISI, Google Scholar ↩︎

- Nagasawa M, Murai K, Mogi K, Kikusui T

. 2011 Dogs can discriminate human smiling faces from blank expressions. Anim. Cogn. 14, 525–533. (doi:10.1007/s10071-011-0386-5) Crossref, PubMed, ISI, Google Scholar, Proops L, McComb K., 2012, Cross-modal individual recognition in domestic horses (Equus caballus) extends to familiar humans. Proc. R. Soc. B282, 3131–3138. (doi:10.1098/rspb.2012.0626) Link, ISI, Google Scholar ↩︎ - Racca A, Guo K, Meints K, Mills DS., 2012 Reading faces: differential lateral gaze bias in processing canine and human facial expressions in dogs and 4-year-old children. PLoS ONE 7, e36076. (doi:10.1371/journal.pone.0036076) Crossref, PubMed, ISI, Google Scholar; ↩︎

- Proops L, McComb K, Reby D., 2009 Cross-modal individual recognition in domestic horses (Equus caballus). Proc. Natl Acad. Sci. USA 106, 947–951. (doi:10.1073/pnas.0809127105) Crossref, PubMed, ISI, Google Scholar ↩︎

- Guo K, Meints K, Hall C, Hall S, Mills D., 2009 Left gaze bias in humans, rhesus monkeys and domestic dogs. Anim. Cogn. 12, 409–418. (doi:10.1007/s10071-008-0199-3) Crossref, PubMed, ISI, Google Scholar ↩︎

- Ghazanfar AA, Logothetis NK., 2003 Facial expressions linked to monkey calls. Nature 423, 937–938. (doi:10.1038/423937a) Crossref, PubMed, ISI, Google Scholar ↩︎

- Racca A, Guo K, Meints K, Mills DS., 2012 Reading faces: differential lateral gaze bias in processing canine and human facial expressions in dogs and 4-year-old children. PLoS ONE 7, e36076. (doi:10.1371/journal.pone.0036076) Crossref, PubMed, ISI, Google Scholar ↩︎

- Somppi S, Törnqvist H, Hänninen L, Krause C, Vainio O., 2014 How dogs scan familiar and inverted faces: an eye movement study. Anim. Cogn. 17, 793–803. (doi:10.1007/s10071-013-0713-0) Crossref, PubMed, ISI, Google Scholar ↩︎

- Holden E, Calvo G, Collins M, Bell A, Reid J, Scot EM, Nolan AM., 2014 Evaluation of facial expression in acute pain in cats. J. Small Anim. Pract. 55, 615–621. (doi:10.1111/jsap.12283) Crossref, PubMed, ISI, Google Scholar ↩︎

- Racca A, Guo K, Meints K, Mills DS. 2012 Reading faces: differential lateral gaze bias in processing canine and human facial expressions in dogs and 4-year-old children. PLoS ONE 7, e36076. (doi:10.1371/journal.pone.0036076) Crossref, PubMed, ISI, Google Scholar; Fukuzawa M, Mills DS, Cooper JJ., 2005 The effect of human command phonetic characteristics on auditory cognition in dogs (Canis familiaris). J. Comp. Psychol. 119, 117–120. (doi:10.1037/0735-7036.119.1.117) Crossref, PubMed, ISI, Google Scholar ↩︎

- Müller CA, Schmitt K, Barber ALA, Huber L., 2015 Dogs can discriminate emotional expressions of human faces. Curr. Biol. 25, 601–605. (doi:10.1016/j.cub.2014.12.055) Crossref, PubMed, ISI, Google Scholar ↩︎